جدول المحتويات

في السنوات الأخيرة، انتقل مفهوم الأسلحة الذاتية التحكم، التي تُعرف أحيانًا بـ”الروبوتات القاتلة”، من عالم الخيال العلمي إلى واقع ملح. هذه الأسلحة المدعومة بالذكاء الاصطناعي أثارت نقاشات حادة بين التقنيين والأخلاقيين وواضعي السياسات. يتناول هذا المقال صعود الأسلحة الذاتية التحكم، والتكنولوجيا وراءها، وأمثلة من الواقع، والتداعيات الأخلاقية والقانونية. سنستكشف أيضًا مستقبل الحروب وما إذا كان بإمكان البشرية السيطرة على انتشار هذه الأدوات التي قد تكون مدمرة.

ظهور الأسلحة الذاتية: حقبة جديدة من الحروب

ظهور الأسلحة الذاتية يمثل تحولاً كبيراً في الحروب الحديثة. على عكس الأسلحة التقليدية التي تتطلب تدخلاً بشرياً، تستطيع الأسلحة الذاتية تحديد الأهداف واستهدافها ومهاجمتها دون الحاجة لسيطرة بشرية مباشرة. هذا التحول مدفوع بالتقدم في مجال الذكاء الاصطناعي وتعلم الآلة، والذي مكن الآلات من أداء مهام معقدة بدقة متزايدة.

وفقًا لتقرير صادر عن معهد ستوكهولم الدولي لأبحاث السلام (SIPRI)، بلغ الإنفاق العسكري العالمي في عام 2020 قرابة 2 تريليون دولار، حيث تم تخصيص جزء كبير من هذه المبالغ لتطوير أنظمة الذكاء الاصطناعي والأنظمة الذاتية. هذا الاستثمار يعزز الأهمية المتزايدة لهذه التقنيات في استراتيجيات الدفاع الوطنية. ومع ذلك، يثير صعود الأسلحة الذاتية تساؤلات حاسمة حول المسؤولية والأخلاقيات وإمكانية إساءة الاستخدام.

ما هي الروبوتات القاتلة؟ المفهوم.

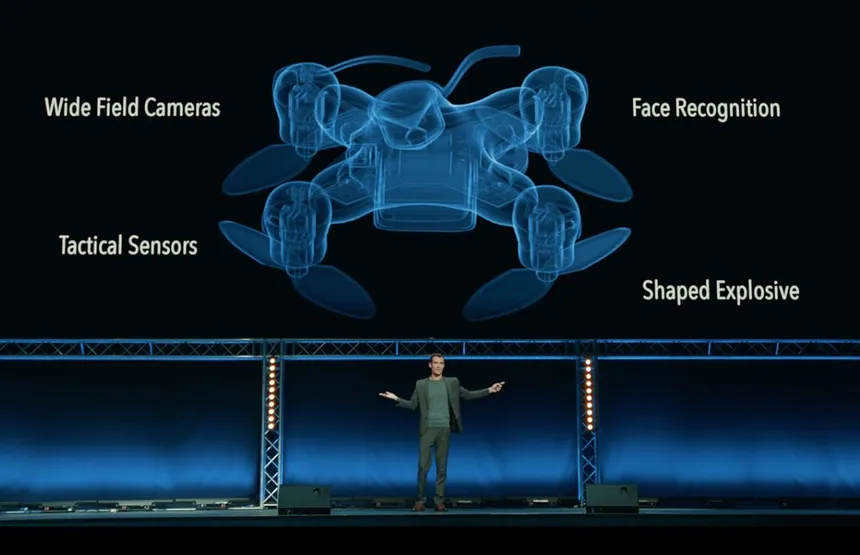

الطائرات القاتلة، مصطلح أصبح شائعًا بفضل فيديو فيروسي أنتجه معهد مستقبل الحياة، يشير إلى طائرات صغيرة تعمل بالذكاء الاصطناعي ومصممة للقتل بدقة. يمكن لهذه الأجهزة العمل بشكل مستقل، مستخدمة التعرف على الوجوه وأجهزة استشعار أخرى لتحديد وإزالة الأهداف. لقد أثار الفيديو، الذي يصور مستقبلًا مرعبًا تُستخدم فيه الطائرات القاتلة للاغتيالات المستهدفة، قلقًا واسع النطاق ونقاشات حادة.

فكرة الروبوتات القاتلة ليست خيالية تمامًا. في عام 2017، عقدت الأمم المتحدة مناقشات حول نظم الأسلحة الذاتية الفتاكة (LAWS)، مشددة على الحاجة الملحة لقوانين دولية. إمكانيات استخدام هذه الأسلحة في الحروب والإرهاب وحتى في حفظ الأمن الداخلي دفعت البعض للمطالبة بفرض حظر استباقي. وينتقد المعارضون استخدام الروبوتات القاتلة بحجة أن نشرها قد يؤدي إلى سباق تسلح جديد، مع عواقب مدمرة على الأمن العالمي.

التكنولوجيا وراء الأسلحة التي تعمل بالذكاء الاصطناعي

التكنولوجيا التي تشغل الروبوتات القاتلة هي مزيج من الذكاء الاصطناعي، التعلم الآلي، والروبوتات المتقدمة. تُمكن الخوارزميات الذكية هذه الأسلحة من معالجة كميات هائلة من البيانات، التعرف على الأنماط، واتخاذ القرارات في الوقت الفعلي. يسمح لها التعلم الآلي بتحسين أدائها مع مرور الوقت والتكيف مع البيئات والتهديدات الجديدة.

أحد المكونات الرئيسية للأسلحة المعتمدة على الذكاء الاصطناعي هو الرؤية الحاسوبية، التي تمكّن الآلات من تفسير المعلومات البصرية. تُستخدم هذه التقنية في أنظمة التعرف على الوجه، والتي تستطيع تحديد الأفراد بدقة عالية. بالإضافة إلى ذلك، تتضمن الأسلحة المعتمدة على الذكاء الاصطناعي عادةً أجهزة استشعار وأنظمة اتصال تتيح لها التنسيق مع أجهزة أخرى ومع المشغلين البشريين. يجمع دمج هذه التقنيات بين الأدوات القوية والتي قد تكون قاتلة في نهاية المطاف.

أمثلة من العالم الحقيقي: هل الروبوتات القاتلة موجودة بالفعل؟

في حين أن الروبوتات القاتلة ذاتية التحكم بالكامل قد لا تزال في مرحلة التطوير، تشير عدة أمثلة واقعية إلى أن هذه التكنولوجيا تتقدم بسرعة. في عام 2020، نشرت القوات العسكرية الأمريكية طائرة بدون طيار من طراز MQ-9 Reaper، والتي يمكنها العمل بشكل مستقل في مهام معينة، مثل المراقبة والاستطلاع. وعلى الرغم من أن العمليات القاتلة للطائرة لا تزال تحت تحكم المشغلين البشريين، إلا أن تزايد استقلالية هذه الأنظمة واضح.

مثال آخر هو الطائرة بدون طيار الإسرائيلية “هاربي”، التي تم تصميمها للكشف عن أنظمة الرادار وتدميرها بشكل مستقل. يمكن لهذا السلاح المتجول أن يعمل دون تدخل بشري، حيث يتخذ القرارات بناءً على معايير مبرمجة مسبقاً. تشير هذه الأمثلة إلى أن الخط الفاصل بين الأسلحة شبه الذاتية والأسلحة الذاتية بالكامل أصبح أكثر غموضاً.

الأبعاد الأخلاقية والقانونية للأسلحة ذاتية التحكم

يثير استخدام الأسلحة الذاتية العديد من الأسئلة الأخلاقية والقانونية العميقة. إحدى القضايا الرئيسية هي مسألة المساءلة. إذا ارتكب روبوت قاتل خطأً أو استُخدم بنوايا خبيثة، من يتحمل المسؤولية؟ قد يؤدي غياب آليات مساءلة واضحة إلى وضع لا يُحاسب فيه أحد على الوفيات الخاطئة أو الأضرار الأخرى.

من منظور قانوني، يثير استخدام الأسلحة الذاتية تحديات أمام الأطر القائمة للقانون الدولي الإنساني. قد يكون من الصعب الالتزام بمبادئ التمييز والتناسب، التي تتطلب من المقاتلين التفرقة بين الأهداف العسكرية والمدنيين واستخدام القوة بشكل متناسب، عند استخدام الأنظمة الذاتية. دعت منظمة هيومن رايتس ووتش ومنظمات أخرى إلى حظر الأسلحة الذاتية بالكامل، بحجة أنها لا تستطيع الامتثال لهذه المعايير القانونية.

مستقبل الحرب: هل يمكننا التحكم في انتشار الروبوتات القاتلة؟

مع تطور التكنولوجيا وراء الأسلحة الذاتية التشغيل بشكل مستمر، تصبح مسألة التحكم أكثر إلحاحاً. هل يمكن للتنظيمات الدولية أن تمنع بشكل فعال انتشار الروبوتات القاتلة؟ بعض الخبراء يرون أن حظرًا استباقيًا، مشابهًا للمعاهدات المتعلقة بالأسلحة الكيميائية والبيولوجية، ضروري لمنع سباق تسلح جديد.

ومع ذلك، يعتقد آخرون أن التنظيم وحده قد لا يكون كافياً. الطبيعة ذات الاستخدام المزدوج لتكنولوجيا الذكاء الاصطناعي، التي يمكن استخدامها لأغراض مدنية وعسكرية، تعقد الجهود المبذولة للتحكم في انتشارها. بالإضافة إلى ذلك، يمكن للجهات غير الحكومية، مثل المنظمات الإرهابية، أن تطور أو تحصل على أسلحة ذاتية التحكم، مما يزيد من تفاقم التهديد.

خلاصة

يمثل صعود الأسلحة ذاتية التشغيل حقبة جديدة من الحروب، مع تأثيرات عميقة على الأمن العالمي والأخلاق والقانون. وبينما تتطور التكنولوجيا وراء الروبوتات القاتلة بسرعة، فإن الأطر الأخلاقية والقانونية اللازمة لتنظيم استخدامها لا تزال متأخرة. وتشير أمثلة من العالم الواقعي إلى أن الأنظمة شبه الذاتية تُستخدم بالفعل، وأن الأسلحة ذاتية التشغيل بالكامل قد تكون قريبة الحدوث.

من المحتمل أن يتحدد مستقبل الحروب بناءً على القرارات التي تُتخذ اليوم بشأن تطوير وتنظيم الأسلحة المدعومة بالذكاء الاصطناعي. سيكون من الضروري اتباع نهج متوازن يجمع بين وجهات نظر متنوعة وتعاون دولي قوي لضمان تحقيق فوائد هذه التقنيات مع تقليل مخاطرها. ونحن نقف على مشارف هذه الحقبة الجديدة، يبقى السؤال: هل يمكننا السيطرة على انتشار الروبوتات القاتلة، أم ستسيطر هي علينا؟